作者:牛逼的IT

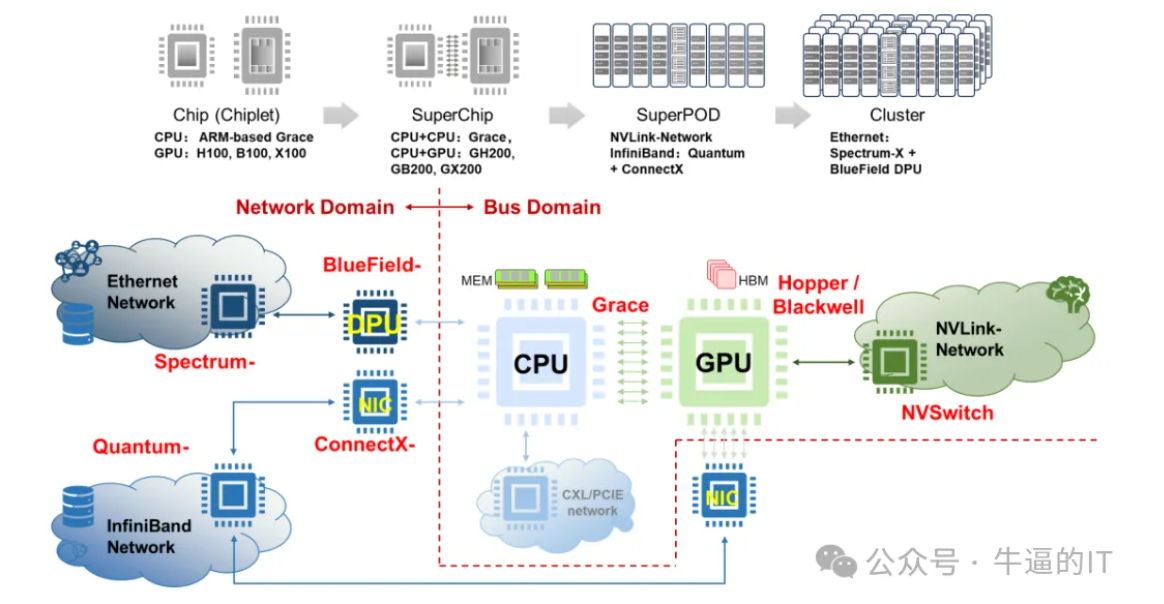

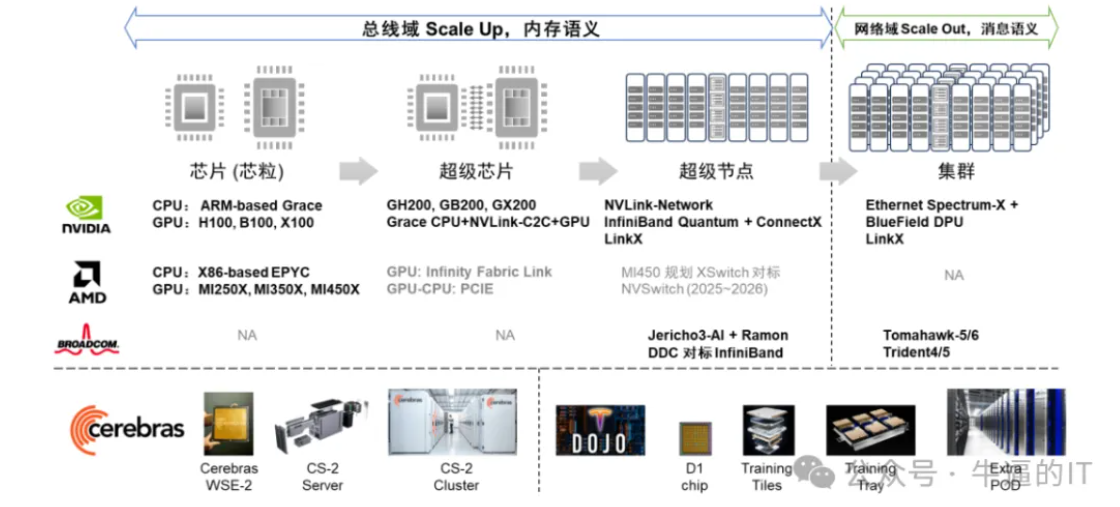

在后摩尔定律时代,随着芯片制造工艺逐渐逼近物理极限,单颗GPU的计算性能因制造工艺(如主频、晶体管数量、最大光照面积等)的限制而难以在短期内实现大幅跃升。针对AI大模型训练的需求,由于单卡浮点计算性能、内存存储空间等因素的制约,必须依赖多种并行技术(如张量并行、流水并行、数据并行等)来突破瓶颈。而这些并行技术的有效运用,则高度依赖于高效的网络互联技术,如NVLink、InfiniBand和以太网等。

随着AIGC革命时代的到来,美国为遏制中国AI领域的崛起,多次发布“禁令”,限制先进GPU和AI算力卡对中国的出口,其标准涵盖单位算力密度和精度等关键指标,意图实现科技封锁。然而,英伟达为维持部分中国市场份额,巧妙调整产品策略,推出了面向中国市场的H20产品。通过降低单卡算力性能,同时增加卡间互联带宽的设计,H20不仅规避了美国的禁令,还为中国用户提供了通过大规模服务器机外互联组网来满足特定训练场景需求的解决方案(推理场景则对GPU卡间数据互访需求不高)。

当前,中国正加速发展自主AI算力卡行业,众多优秀的AI卡/GPU卡公司(如鲲鹏、寒武纪、昆仑芯、遂源、摩尔线程、海光等)正积极投入新产品的研发。然而,受技术积累、芯片制造工艺和软件生态等多方面的差距影响,中国AI算力卡的单卡性能指标与国际先进水平相比仍有差距。因此,要实现AI大模型训练接近国际顶级水平的目标,不仅需要更多的AI算力卡支持,更需借助高效的网络互联解决方案来推动大规模AI集群的互联互通。

在AI训练的宏大场景中,网络需求已跃升至全新高度:必须支持超大规模组网(涵盖千卡、万卡乃至数十万卡级别)、确保高吞吐能力(单端口带宽从100G到1.6T,实现多链路负载均担)、追求极低的延时(纳秒级别)、确保数据传输的无损性(借助精细化流控技术)、实现快速故障恢复(毫秒级监控与响应)、以及优化All-reduce算法以适应在网计算的需求。这些严苛的要求使得AI时代的以太网高速互联解决方案变得与GPU单卡算力能力同样关键(NVLink、InfiniBand为英伟达私有解决方案,且IB也不太适用于超大规模组网)。

鉴于这一趋势,我们不得不深思:倘若美国未来对AI训练的高端以太网络解决方案实施禁售,我们国产的网络解决方案是否能够担当起国产化替代的重任?接下来,我们将围绕这一话题展开讨论,共同探寻国产网络解决方案的潜力和挑战。

国产化交换机单机性能

从目前国内主流网络厂商(华为、华三、中兴、锐捷等)的信息来看,各家都发布了国产化(即核心关键元器件:CPU、交换芯片等为国产)数据中心交换机产品,基本情况如下:

1、机框式交换机:主要有4槽位、8槽位、16槽位三个档次,适用于AI场景的业务卡类型包括:48口100G、36口200G、36口400G;以16槽交换机为例,整机最大接口密度为48*16=768口100G或36*16=576口200G\400G。

2、单芯片盒式交换机:据分析国产最高交换容量可达25.6T,AI场景下各厂家主要有4款接口形态产品:128口100G、128口200G、64口200G、64口400G;

能力分析:机框式设备性能档次及接口形态与非国产化同类型产品基本保持一致,但由于机框式设备业务卡、交换网卡是多芯片互联架构,功耗(高)、成本(高)、时延(大)受这些因素的影响,其实不太适合AI场景,更适合行业客户(不包括互联网行业)的通算场景;

单芯片盒式交换产品与非国产化产品存在一个代差,非国产化产品最高交换容量可达51.2T,具备更高的128口400G形态,但国产化产品已经可以满足绝大部分行业客户需求(头部互联网公司BBAT除外);

国产化AI方案组网模式

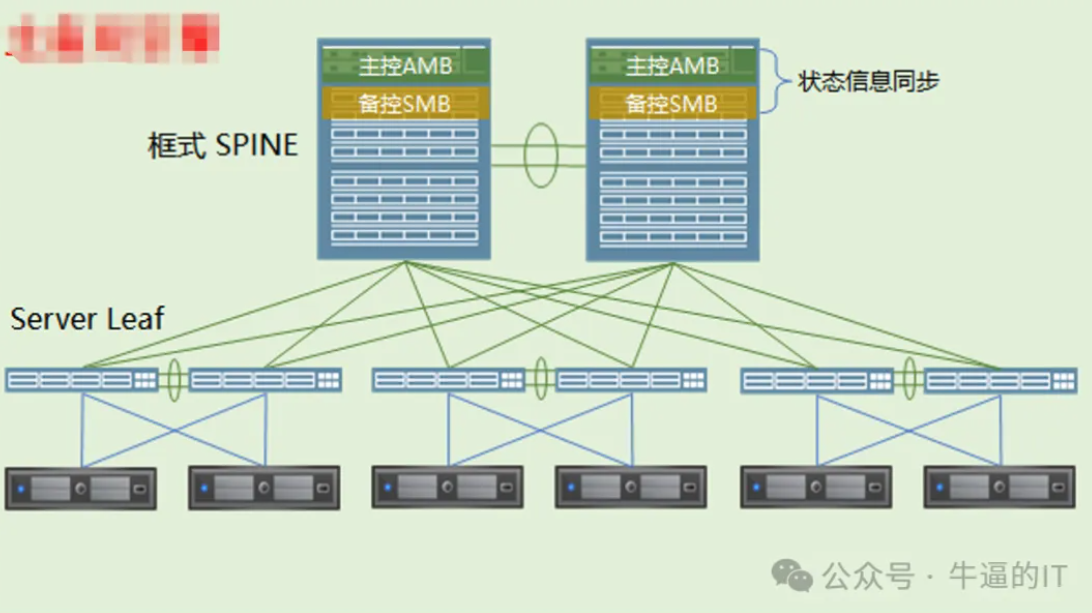

1、框框组网:接入、汇聚交换机均采用框式交换机,按最大16槽交换机,按单台200G\400G最大接口密度为576口计算,两层组网下,支持的最大组网规模为:8.29万卡(288台接入+144台汇聚,以上为理论值,实际机框设备大规模组网不现实);

- 优势:理论的组网规模大,且更符合行业客户旧有习惯;

- 劣势:成本极高、功耗极大、时延高、单台故障域大、布线难度高(相当于4层盒盒组网);

- 适合:不差钱、不太关注AI训练效率(只想蹭AI热度)的客户;

2、盒框组网:接入采用盒式交换机,汇聚采用框式交换机,以200G接口需求为例,两层组网下,支持的最大组网规模为:3.68万卡(576台128*200G接入+64台16槽框式汇聚);

- 优势:组网规模较大,符合行业客户旧有习惯;

- 劣势:成本高、功耗较大、时延较高(相当于3层盒盒组网);

- 适合:有大规模组网需求,但网络规划能力一般的客户;

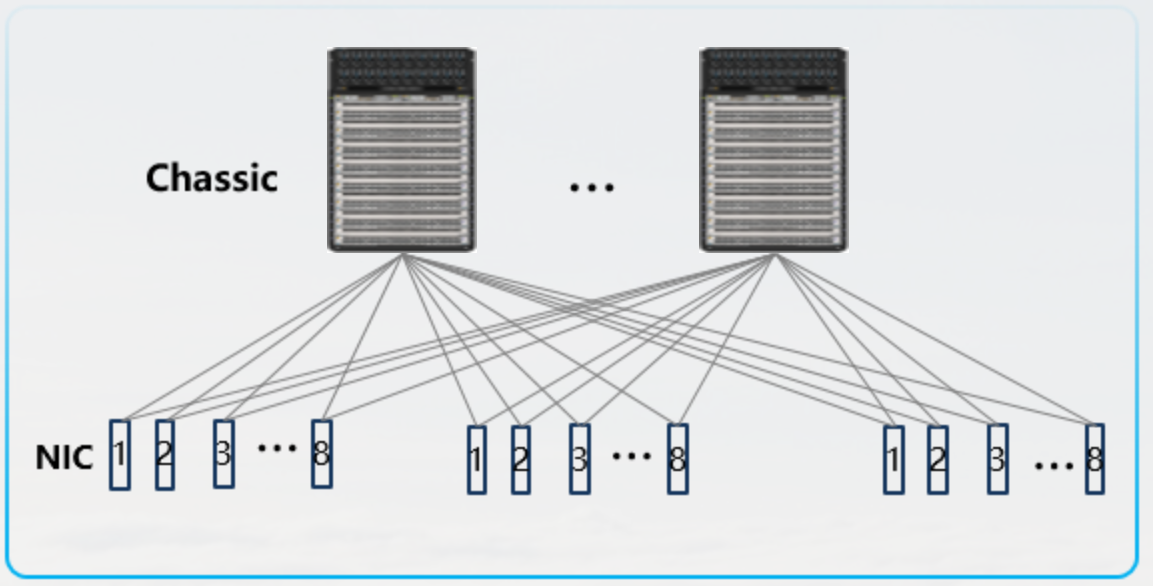

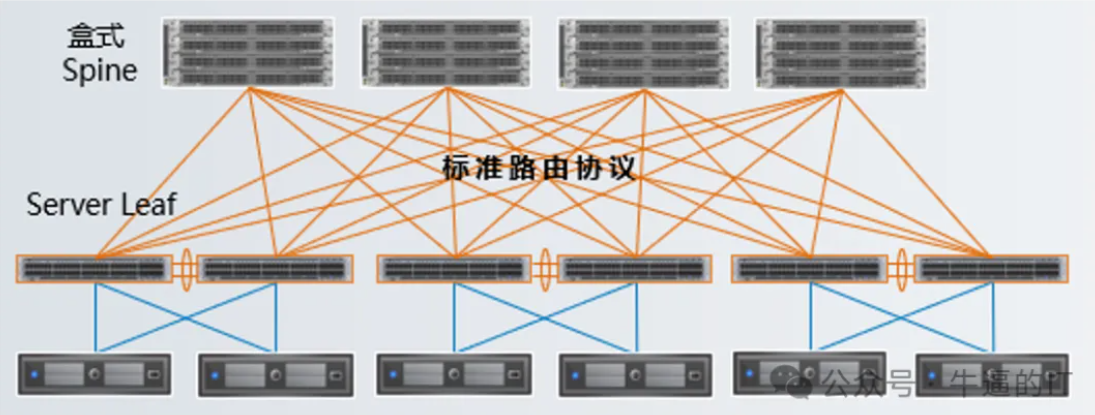

3、盒盒组网:接入、汇聚均采用盒式交换机,同样以200G接口需求为例,两层组网下,支持的最大组网规模为:0.8万卡(128台128*200G接入+64台128*200G汇聚);三层组网下,可支持50万卡以上的组网规模(400G接口,两层组网支持2K卡,三层组网支持6.5万卡);

- 优势:组网成本低、时延低、功耗低、网络解耦透明,

- 劣势:两层组网规模较低(但已经可以满足绝大部分组网规模需求,如果有更大规模需求,可进行三层网络搭建);

- 适合:几乎适合所有类型客户(根据不同需求选择2层或3层组网);

国产化AI网络功能特性

流控技术:为防止AI网络侧因“多打一”、“超额订阅”、“负载不均衡”等原因产生的网络拥塞问题,需要网络支持精细化流量控制能力,目前国产交换机均支持PFC、ECN流控功能(包括PFC死锁检测、headroom缓存优化、快速ECN等特性);

虽然英伟达、UEC联盟等都在交换机侧支持(或规划)新的流控技术(如: 类似IB的基于信用的缓存提前申请机制,或通过集中控制器调度的动态拥塞水线调整能力),但目前网络设备侧主流的流控技术仍是成熟的PFC、ECN技术;

未来网络流控技术可能得演进方向主要是在“端侧”,通过网卡感知网络时延、抖动、丢包情况,实时调整端侧的流量速率,实现网络的“无拥塞”(部分互联网大厂已经通过自研的网卡实现了端侧流控能力)。

负载均衡技术:为提升AI网络的互联带宽、提升网络的可靠性,接入与汇聚交换机之间都采用多链路互联组网,网络数据需要在多链路上做ECMP负载均衡转发,常见的DCN链路负载均衡技术包括:基于流的哈希负载,基于Flowlet 流负载、基于数据包的包喷洒负载,基于等长信元(Cell)的喷洒负载;

目前实际普遍使用的链路负载均衡技术让是基于Flowlet 的流负载模式,这样既符合传统基于流转发的网络运维习惯,又能通过Flowlet将大象流按一定的“流间隙”进行拆分细化(AI场景下,可以人为构建一定的流间隙),这样既可以保证报文不乱序,又能提升链路利用率,减少哈希负载不均衡的问题;

英伟达、博通虽然支持基于包和信元的喷洒负载,可以进一步提升网络带宽的利用率,但因需要再网卡侧或汇聚交换机侧解决“报文或信元的重排序问题”,也会带来建设成本提升、运维模式改变的挑战,目前这两种负载模式只有少数互联网公司在进行试点测试。

上面说的链路负载技术,是按照数据转发的不同颗粒度来划分的,但不管是那种颗粒度的链路负载,都会存在由于某种原因(哈希不均衡、多打一、超额订阅等)出现负载“不合理”的现象,这时就需要通过DLB、GLB等技术,根据本交换机接口或对端交换机接口的队列的流量实时情况(缓存情况、带宽占用情况等),来动态调整链路负载均衡的比例,从而减少网络中链路拥塞情况的发展,并让网络负载更加均衡,网络带宽的利用率更高;

网络监控技术:在AI场景下,网络监控技术变得尤为重要,因为AI应用,特别是涉及大规模数据处理和模型训练的应用,对网络的性能和稳定性有着极高的要求。

更快的故障恢复能力:AI应用通常需要连续不间断的网络服务,任何网络中断都可能导致数据处理延迟或模型训练失败。因此,网络监控系统需要能够迅速检测到故障,并自动或手动触发恢复流程,以最小化停机时间。

更少的网络丢包:网络丢包会导致数据完整性受损,影响AI模型的训练质量和预测准确性。网络监控应能实时监测丢包率,并采取措施减少丢包,如动态路径优化或负载均衡。

更低的尾时延:尾时延是指网络中最慢的那部分数据包的传输时间,这在高并发请求的AI应用中尤为重要。网络监控需能够识别和优化导致尾时延增加的因素,如瓶颈链路或设备性能瓶颈。

为了满足AI场景对网络的更高要求,现代网络监控技术正朝着更精细化的方向发展,其中两个关键特性是INT和MOD,通过这两种技术,可以更准确的实时反馈网络数据的转发状态(数据转发路径、时延、缓存情况、丢包原因等),帮助管理员快速诊断网络问题,优化流量路径,减少丢包和降低尾时延。

总结

网络本来就是所有IT基础设施的“血管脉络”,连接和承载所有的上层应用。随着AI时代的降临,网络更是跃升为大规模数据和算力流动的关键驱动力,其重要性不言而喻。

由于一系列复杂的因素,我们不得不将目光投向国产化AI网络的建设。虽然目前国产AI网络方案在性能上与英伟达、博通等国际巨头还存在一定的差距,但值得欣慰的是,它已具备满足国内绝大部分客户AI组网需求的能力。当然,我们也应认识到,由于规模和成本的考量,少数头部互联网公司可能暂时无法完全采用国产网络方案,但这正是我们持续努力、不断优化的动力所在。

未来,有理由相信,随着技术的不断进步和市场的日益成熟,国产AI网络将在性能和功能上不断接近甚至超越国际水平,为我国的信息安全和科技创新提供强有力的支撑。